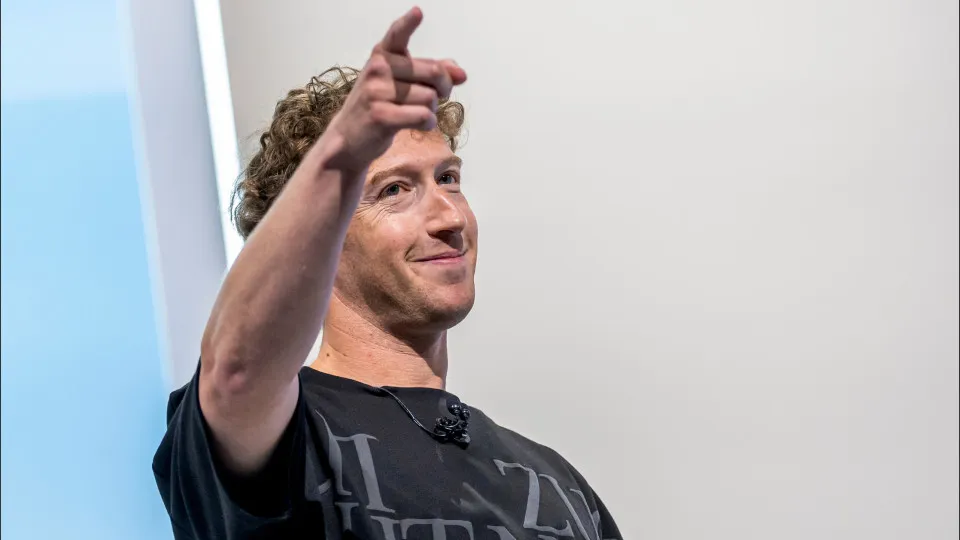

O CEO da Meta, Mark Zuckerberg, esteve no centro das atenções nesta semana, negando veementemente durante um julgamento que o Instagram tenha como alvo principal crianças menores de idade. A audiência, que atraiu grande visibilidade, focou nas crescentes preocupações sobre a segurança e o impacto das redes sociais na saúde mental de jovens usuários globalmente.

Zuckerberg afirmou em diversas ocasiões que a plataforma é projetada para usuários a partir de 13 anos, enfatizando que a Meta implementa uma série de ferramentas e políticas para coibir o acesso de crianças e proteger adolescentes. Este depoimento é mais um capítulo na pressão sobre as gigantes da tecnologia para garantir ambientes online mais seguros.

O Contexto do Julgamento e as Acusações Contra a Meta

A audiência faz parte de um conjunto de processos e investigações que buscam responsabilizar a Meta e outras empresas de tecnologia pelo suposto impacto negativo de seus produtos em crianças e adolescentes. Pais, legisladores e defensores da segurança digital têm expressado grande preocupação com algoritmos que podem expor jovens a conteúdos inapropriados ou criar padrões de uso potencialmente viciantes.

As acusações contra o Instagram frequentemente citam estudos e depoimentos que sugerem que a empresa estaria ciente dos riscos e, ainda assim, não agiu de forma suficiente. O foco principal tem sido na capacidade dos algoritmos de reter a atenção dos usuários e na exposição a padrões de beleza irrealistas, que podem afetar a autoestima dos mais jovens, especialmente as adolescentes.

Pressão Legislativa por Regulamentação de Idade

Legisladores em diversos países têm intensificado a pressão por regulamentações mais rigorosas, incluindo a verificação de idade mais robusta e a criação de ambientes mais seguros para adolescentes online. A discussão sobre a segurança digital dos jovens não é nova, mas ganhou força com o aumento da conscientização sobre os perigos da internet para as faixas etárias mais vulneráveis. O CEO da Meta foi questionado extensivamente sobre como a empresa lida com essas exigências e as diretrizes regulatórias.

O Children's Online Privacy Protection Act (COPPA), nos Estados Unidos, é um exemplo de lei que visa proteger a privacidade online de crianças menores de 13 anos. Contudo, críticos argumentam que as plataformas não fazem o suficiente para cumprir tais diretrizes, especialmente no que diz respeito ao Instagram e seus usuários abaixo da idade mínima declarada. A complexidade do cenário digital desafia a implementação de regras eficazes e fiscalização.

Entidades de proteção à criança e à privacidade têm defendido que as plataformas deveriam adotar um design 'por padrão de segurança', garantindo que a proteção dos menores seja prioridade desde o início do desenvolvimento de qualquer serviço ou recurso. Essa abordagem proativa contraria a ideia de que a responsabilidade primária recai apenas sobre os pais.

A Defesa de Zuckerberg e as Iniciativas da Meta

Em sua defesa, Mark Zuckerberg reiterou o compromisso da Meta com a segurança de todos os usuários, especialmente os adolescentes. Ele destacou que a empresa investe bilhões de dólares anualmente em segurança e desenvolve tecnologias de inteligência artificial para identificar e remover contas de menores de 13 anos. A Meta busca constantemente equilibrar a inovação com a responsabilidade social em suas plataformas digitais.

O CEO enfatizou que o Instagram não é projetado com o objetivo de atrair crianças, mas sim adolescentes acima da idade mínima estabelecida. Ele argumentou que a plataforma oferece muitos benefícios, como a conexão social, a expressão criativa e o desenvolvimento de habilidades digitais, desde que utilizada de forma saudável e com as devidas supervisões por parte dos responsáveis.

Ferramentas de Proteção e Controle Parental do Instagram

A Meta tem introduzido uma série de ferramentas de controle parental e recursos de segurança aprimorados, permitindo que pais e responsáveis monitorem o tempo de uso de seus filhos adolescentes. Essas ferramentas também permitem visualizar quem eles seguem e quem os segue, além de receber notificações sobre denúncias feitas pelos jovens. Tais funcionalidades visam dar mais poder às famílias na gestão da experiência online de seus filhos.

Outras iniciativas incluem a desativação de mensagens diretas de adultos para adolescentes que não os seguem, e a remoção proativa de conteúdos que violam as políticas de comunidade da plataforma, como aqueles que promovem a automutilação, transtornos alimentares ou cyberbullying. A empresa busca constantemente aprimorar seus mecanismos de moderação para proteger a integridade dos usuários, especialmente os mais jovens.

A verificação de idade no Instagram também tem sido um ponto de aprimoramento contínuo. A plataforma utiliza uma combinação de inteligência artificial, além de solicitar documentos de identificação em alguns casos, para tentar identificar a idade real dos usuários no momento da criação da conta. Este esforço é vital para garantir que apenas pessoas com idade permitida acessem as funcionalidades completas da rede social, protegendo o ambiente digital de crianças.

A Meta destacou ainda que está em constante diálogo com especialistas em segurança infantil, psicólogos e educadores para refinar suas políticas e recursos. A colaboração com diversos setores é vista como crucial para enfrentar os complexos desafios da segurança digital e do bem-estar dos jovens em plataformas online.

O Debate Contínuo: Equilíbrio entre Inovação e Segurança Digital

A audiência de Mark Zuckerberg reflete um dilema global: como as plataformas digitais podem continuar inovando e oferecendo seus serviços sem comprometer a segurança e o bem-estar de seus usuários mais jovens? A questão é complexa e envolve tecnologia avançada, legislação, educação digital e a responsabilidade individual de usuários e pais. A busca por um ambiente online saudável e seguro é um objetivo compartilhado.

O caso do Instagram e crianças é um microcosmo do desafio mais amplo enfrentado pela indústria da tecnologia. Enquanto as empresas defendem seus esforços em segurança, críticos argumentam que os modelos de negócios baseados na atenção e no engajamento criam incentivos para designs que podem ser prejudiciais, especialmente para mentes em desenvolvimento. O diálogo contínuo entre todas as partes interessadas é fundamental para construir um futuro digital mais seguro para todos.

Próximos Passos na Regulamentação Digital Global

A pressão sobre o Congresso e outros órgãos legislativos em todo o mundo para aprovar novas leis de segurança online para crianças e adolescentes deve continuar. Propostas legislativas incluem a exigência de avaliações de risco independentes para produtos digitais voltados para jovens e a imposição de limites sobre como os dados de menores podem ser coletados e utilizados por empresas de tecnologia. A expectativa é que o debate resulte em diretrizes mais claras e eficazes.

Este julgamento pode ser um catalisador para mudanças significativas na forma como as redes sociais operam e interagem com seus usuários mais jovens. O desfecho dessas discussões terá implicações duradouras para o futuro da segurança digital e a responsabilidade das empresas de tecnologia. O cenário está em constante evolução, exigindo adaptação contínua e um compromisso renovado com a proteção dos mais vulneráveis no ambiente online.

A Meta continua a defender suas políticas e inovações, argumentando que a colaboração com pais, educadores e governos é a melhor maneira de criar um ambiente online positivo e construtivo. A empresa reafirma seu compromisso em evoluir suas ferramentas e estratégias, buscando um equilíbrio que promova a conectividade segura e a expressão criativa para todos os seus usuários, sem comprometer a integridade dos menores de idade.

Acompanhe atualizações aqui na Academia Nerds.

Deixe um comentário